- A+

一、Helium 10 API 核心数据接口解析与权限配置

1. 核心数据接口功能与调用逻辑

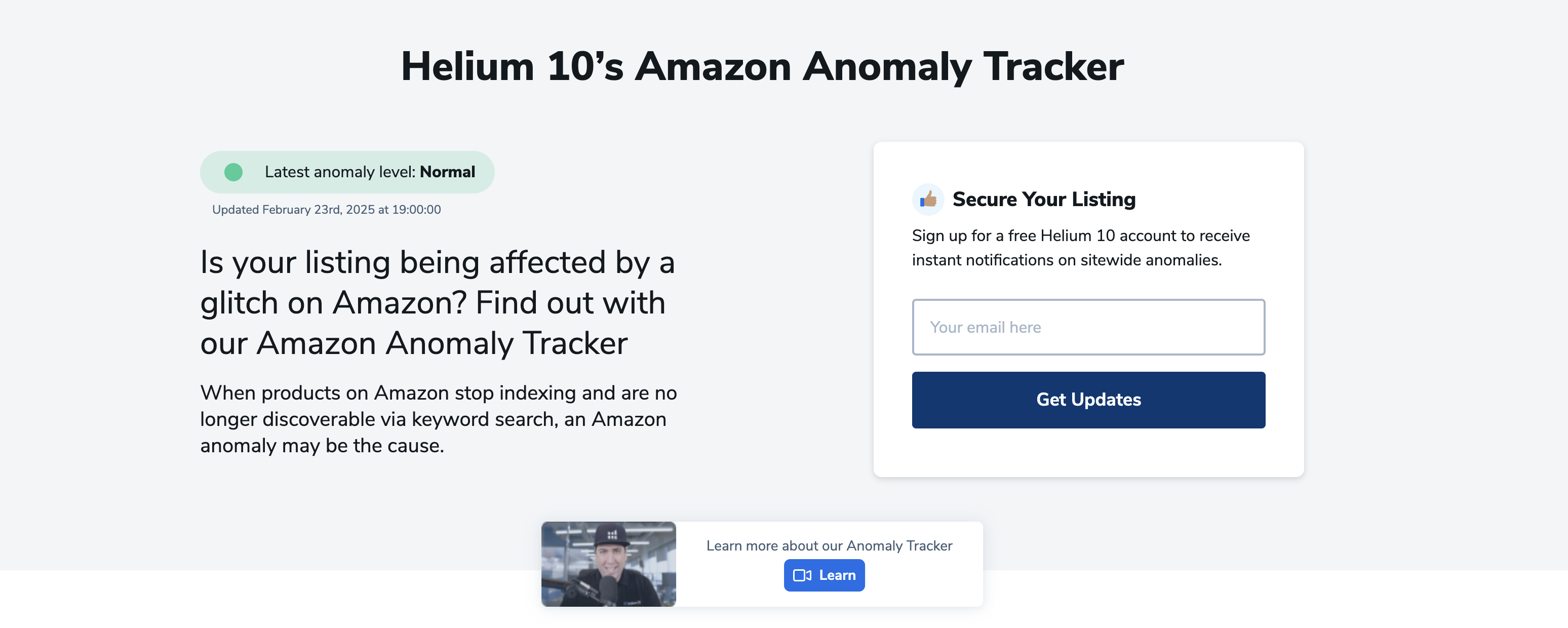

helium 10 API 提供了多维度的数据接口,覆盖关键词分析、产品监控、竞品追踪等核心功能。其中,Xray 接口支持实时商品数据抓取,返回ASIN级别的销售排名、定价趋势及库存状态;Magnet 接口则用于关键词挖掘,通过输入种子词生成高相关性长尾词及其搜索量、竞争度等指标。接口调用需遵循RESTful规范,使用GET或POST请求,并携带Authorization头进行身份验证。例如,获取某ASIN的销售数据可通过/api/v1/products/{asin}/sales端点实现,响应数据为JSON格式,包含销量、BSR(Best Seller Rank)等字段。调用频率限制为每分钟120次,超时请求将返回429 Too Many Requests错误。

2. 权限分级与安全配置

API权限基于OAuth 2.0协议管理,分为read、write和admin三级。read权限仅允许访问数据查询接口,如Black Box的筛选结果;write权限支持操作指令,如更新Keyword Tracker的监控列表;admin权限则包含账户管理及子用户分配功能。安全配置需通过开发者后台生成API密钥,并绑定IP白名单以限制访问来源。生产环境建议启用HTTPS协议,并对敏感数据(如利润计算结果)进行AES-256加密。此外,可通过scopes参数动态控制接口权限范围,例如scopes=sales:read,keywords:write仅授予特定模块操作权。

3. 错误处理与性能优化

接口调用可能触发多种错误码,如400 Bad Request(参数缺失)、401 Unauthorized(密钥失效)或500 Internal Server Error(服务异常)。开发者需实现错误重试机制,对临时性故障采用指数退避算法。性能优化方面,建议批量请求合并(如/api/v1/products/batch端点),减少网络开销;同时利用fields参数指定返回字段,避免冗余数据传输。对于高频调用场景,可部署Redis缓存层,存储24小时内的静态数据(如历史销量),降低API压力。

二、Power BI 数据建模:构建选品分析多维数据集

1. 数据源整合与清洗

构建选品分析多维数据集的第一步是高效整合多源数据。常见数据源包括销售交易表、商品库存表、供应商信息及市场趋势数据。在Power Query中,通过合并与追加操作将分散的数据表统一汇总,并利用“转换数据”功能清洗冗余字段、修正错误值(如负库存或异常价格)、标准化日期格式(确保时间维度的一致性)。此外,需建立主键关系(如商品SKU与销售记录的关联),避免数据孤岛,为后续建模奠定基础。

2. 设计核心维度与度量值

数据建模的核心是构建分析维度与关键指标。维度表需涵盖商品类别、品牌、价格区间、地域及时间等属性,确保多角度切片分析。例如,将商品表拆分为“商品属性”(类别、品牌)和“库存动态”(库存量、周转率)两张表,通过雪花模型优化查询效率。度量值(Measures)则是分析的灵魂,需使用DAX(数据分析表达式)定义核心指标,如“销售增长率”(DIVIDE([本期销售]-[上期销售], [上期销售]))、“库存周转天数”(DIVIDE([期末库存], [日均销售]))及“利润贡献率”(DIVIDE([毛利], [销售额]))。动态筛选器(如时间智能函数)可进一步支持同比、环比分析。

3. 优化模型性能与用户交互

为提升数据集响应速度,需采用星型模型设计,将维度表与事实表通过一对多关系连接,并启用列存储索引(VertiPaq引擎)。对高频查询字段(如商品ID或日期)设置排序规则,避免计算错误。在用户交互层面,通过创建层次结构(如“年-季度-月”时间层级)和钻取按钮简化操作逻辑,并利用书签与按钮组合实现“场景切换”(如“选品策略”与“风险预警”视图)。最终,通过Power BI服务发布数据集,并配置行级安全(RLS)确保不同角色权限隔离,保障数据安全。

通过以上步骤,企业可构建一个高效、灵活的选品分析多维数据集,支撑从宏观趋势到微观单品的多维度决策。

三、基于API数据流的自动化选品指标体系设计

在数字化运营中,构建基于API数据流的自动化选品指标体系是提升选品效率和精准度的核心。该体系通过实时接入多源数据,结合动态算法模型,实现从数据采集到决策输出的闭环管理。以下从关键指标构建与动态优化机制两个维度展开设计。

1. 核心指标的多维度构建

自动化选品指标体系需覆盖商品全生命周期,分为基础、动态和预测三类指标。

1. 基础指标:包括商品销量、毛利率、库存周转率等静态数据,通过API从ERP、CRM系统同步,形成选品的基础评估维度。

2. 动态指标:实时捕捉市场变化,如点击率、加购率、竞品价格波动等,通过爬虫API和电商平台接口动态更新,反映商品当前竞争力。

3. 预测指标:基于机器学习模型,结合历史数据与趋势指标(如季节性指数、热搜词增速),生成未来30天的需求预测值,辅助前瞻性选品。

指标间需建立权重关联模型,例如高点击率但低转化率的商品需降低优先级,而高复购率的低流量商品可纳入潜力池。

2. 自动化决策的动态优化机制

指标体系的生命力在于动态调整,需设计三个核心模块:

1. 异常监测模块:通过API数据流阈值触发告警(如销量骤降超20%),自动标记问题商品并暂停推广。

2. A/B测试引擎:对新上架商品分组投放不同流量策略,实时对比转化率数据,自动淘汰低效组。

3. 反馈闭环:将选品结果(如实际销售额)反馈至算法模型,通过强化学习优化指标权重,例如提高对“退货率”的惩罚系数。

此外,需设置人工干预接口,允许运营人员临时调参,确保系统灵活性。

3. 技术架构与数据治理

稳定的技术架构是保障体系运行的关键:

- 数据层:采用Kafka处理高并发API流,ClickHouse存储实时指标,Hive归档历史数据。

- 计算层:Spark Streaming实时计算动态指标,TensorFlow训练预测模型。

- 治理层:通过数据血缘追踪指标来源,制定API调用频率限制(如每分钟不超过100次),避免接口过载。

最终,指标体系以API形式输出选品清单,与下游仓储、营销系统无缝对接,实现全链路自动化。

四、实时数据同步:Helium 10与Power BI的连接器开发

1. 连接器的技术架构与数据流设计

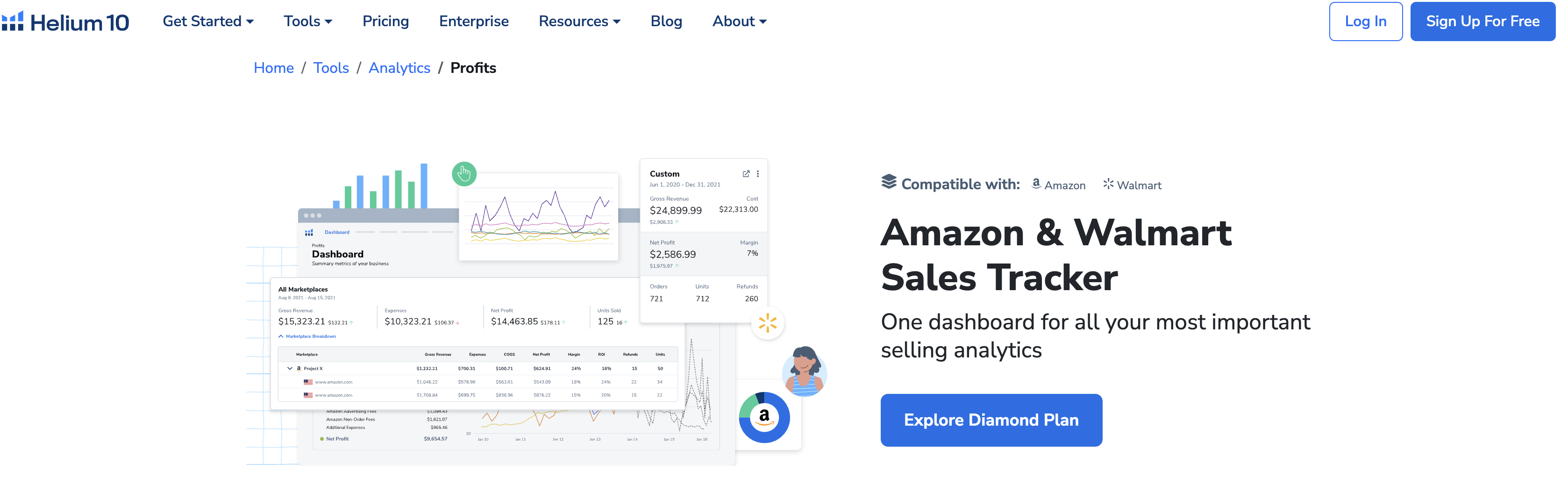

开发Helium 10与Power BI的实时连接器,核心在于构建高效的数据传输管道。首先,通过Helium 10 API获取实时销售、关键词排名、库存等关键指标,采用RESTful协议进行数据拉取,确保与平台数据库的兼容性。数据流设计上,引入增量同步机制,仅传递变更数据,减少网络负载。中间层使用Python或Node.js搭建服务,负责数据清洗、格式转换(如JSON转Parquet),并通过Power BI的Connector SDK实现无缝对接。为保障实时性,采用WebSocket技术推送关键指标更新,确保仪表盘延迟低于5秒。同时,设置缓存层(Redis)存储高频查询数据,避免重复API调用,提升响应速度。

2. 错误处理与性能优化策略

连接器的稳定性依赖于健壮的错误处理机制。针对API限流(如Helium 10的每分钟请求上限),设计动态退避算法,自动调整请求频率;对于网络中断,实现本地缓存与断点续传功能。性能优化方面,采用列式存储压缩数据,减少Power BI导入时间;通过并行查询分片数据,充分利用多核处理能力。此外,引入异常监控模块,实时捕获日志并触发告警,方便运维快速定位问题。测试阶段需模拟高并发场景(如每小时10万次调用),确保连接器在峰值负载下仍能维持稳定性能。

3. 部署与用户场景验证

部署时,提供两种模式:云端服务(Azure Functions)适合企业用户,支持自动扩缩容;本地部署(Docker容器)满足数据合规需求。用户场景验证聚焦于亚马逊卖家的核心需求,例如:1)实时监控广告ACoS与关键词排名,自动生成趋势分析;2)结合历史销售数据预测库存周转,触发补货提醒。通过A/B测试对比连接器与传统CSV导入的数据延迟(平均从30分钟缩短至实时),验证其商业价值。最终,交付时需附加详细的API文档与Power BI模板,降低用户学习成本。

五、竞品监测矩阵:自动化数据抓取与可视化呈现

1. 自动化数据抓取:构建高效监测体系

竞品监测的核心在于实时、全面的数据采集,而自动化数据抓取技术是实现这一目标的关键。首先,需明确监测维度,包括竞品的产品定价、营销活动、用户评价、社交媒体声量等关键指标。其次,利用爬虫工具(如Python的Scrapy框架或第三方平台如Octoparse)设定抓取规则,针对竞品官网、电商平台、新闻媒体及社交渠道进行定向采集。为确保数据准确性,需配置反爬策略(如动态IP代理、请求频率控制),并结合数据清洗算法(去重、异常值过滤)提升信息质量。此外,通过API接口接入第三方数据源(如SimilarWeb流量数据、Sensor Tower应用排行),可补充人工抓取的盲区。最终,将数据存储至结构化数据库(如MySQL或MongoDB),为后续分析奠定基础。

2. 可视化呈现:动态仪表盘与趋势分析

原始数据需通过可视化工具转化为直观洞察。推荐使用Tableau、Power BI或ECharts等平台,设计包含多模块的竞品监测仪表盘。例如,设置“价格监控”模块,横向对比竞品不同SKU的价格波动;配置“用户情感分析”图表,通过NLP技术解析评论数据,以词云或情感倾向分布图呈现口碑变化。趋势分析方面,可结合时间序列图表展示竞品市场份额、搜索指数等指标的动态演变,并设置预警阈值(如价格变动超过5%时触发通知)。此外,利用交互功能(如筛选器、钻取功能)支持多维度下钻分析,帮助团队快速定位异常或机会点。最终,通过定期生成自动化报告(PDF或在线链接),确保决策层实时获取关键情报。

3. 技术落地与持续优化

自动化监测体系的成功部署需兼顾技术可行性与业务适配性。初期可通过MVP(最小可行产品)模式,优先抓取1-2个核心竞品的核心数据,验证抓取逻辑与可视化效果。后续逐步扩展监测范围,并引入机器学习模型(如预测竞品促销周期)。同时,建立数据更新机制(如每日增量抓取)和异常处理流程(如爬虫失效时自动切换备用节点)。定期评估系统性能,结合业务反馈调整监测指标权重,确保矩阵始终与战略目标对齐。通过技术迭代与数据闭环,竞品监测从被动响应升级为主动预警,为企业赢得市场先机。

六、市场趋势预测模型:基于历史数据的DAX公式构建

1. 数据预处理与特征工程

在构建市场趋势预测模型前,数据预处理是确保DAX公式准确性的关键步骤。首先,需从历史交易数据中提取核心指标,如收盘价、成交量、波动率等,并清洗异常值(如极端价格跳变或缺失值)。例如,可通过AVERAGE()平滑短期噪声,或用DATEADD()对齐时间序列。其次,特征工程需结合市场逻辑创建衍生变量,例如:

- 移动平均线趋势:CALCULATE(AVERAGE(TableName[Close]), DATESINPERIOD(Calendar[Date], MAX(Calendar[Date]), -30, DAY))

- 量价背离信号:IF(VOLUME > AVERAGE(VOLUME, 20) && CLOSE < PREVIOUSDAY(CLOSE), 1, 0)

此类特征能捕捉市场动能变化,为后续模型提供多维输入。

2. DAX核心逻辑与回归模型构建

DAX公式的核心在于通过时间序列函数实现动态计算。以线性回归为例,可利用LINESTX()函数拟合历史数据与趋势变量的关系:

TrendModel = LINESTX(

SUMMARIZE(TableName, Calendar[Date]),

[Close],

[MA_30], [Volume_Change]

)

该公式返回斜率和截距,用于预测未来走势。此外,需引入滞后变量(如PREVIOUSDAY(CLOSE))捕捉自相关性,并通过EARLIER()函数构建滚动窗口分析。例如,计算30日波动率的DAX公式为:

Volatility_30D = STDEVX.P(

DATESINPERIOD(Calendar[Date], MAX(Calendar[Date]), -30, DAY),

[Daily_Return]

)

结合多因子回归(如宏观数据、技术指标)可提升模型鲁棒性。

3. 模型验证与误差优化

模型需通过回测验证预测能力。DAX中可使用EVALUATEANDLOG()追踪计算性能,并通过RMSE()或MAE()衡量误差:

RMSE = SQRT(AVERAGEX(Actual_vs_Predicted, POWER([Actual] - [Predicted], 2)))

若误差较大,需调整参数(如移动窗口长度)或引入非线性因子(如EXP()函数处理指数趋势)。最终,部署时建议结合动态可视化(如Power BI趋势线)实时监控预测偏差,确保模型适应性。

七、异常数据预警机制:Power BI自动化警报设置

1. 预警机制的核心逻辑与适用场景

异常数据预警机制是Power BI中实现主动监控的关键功能,通过预设规则自动识别数据偏离,并实时触发通知。其核心逻辑基于阈值监控、趋势突变检测或统计模型(如标准差、四分位数)判断数据异常性。例如,销售额连续3天低于基线20%、库存周转率突增5倍,或用户活跃度偏离7日均值3倍标准差均可触发警报。

适用场景包括:

1. 运营监控:实时追踪KPI(如订单完成率、服务器负载),避免业务中断;

2. 财务风控:监控成本超支、退款率异常,降低财务风险;

3. 质量分析:检测产品缺陷率、客户投诉量突增,快速响应问题。

2. Power BI警报配置的实操步骤

在Power BI中设置警报需结合数据模型与可视化对象,具体步骤如下:

- 选择监控指标:在报表中选中关键图表(如卡片图、折线图),点击右上角“警报”图标。

- 定义触发条件:

- 阈值型:设置绝对值(如“销售额<10万”)或百分比(如“环比下降>15%”);

- 动态基线:利用DAX计算移动平均值(如“近30日均值±2倍标准差”),并引用该字段作为阈值;

- 多条件组合:通过IF函数嵌套逻辑(如“销售额下降且客单价同步降低”)。

- 通知方式配置:

- 邮件通知:指定邮箱收件人,支持自定义消息模板;

- Teams集成:通过Power Automate将警报推送至指定频道;

- API调用:高级用户可结合Webhook对接企业监控系统(如Splunk)。

关键技巧:

- 使用“数据刷新”频率控制警报时效性(建议重要指标设置15分钟间隔);

- 通过“警报规则历史记录”分析误报率,动态优化阈值。

3. 高级优化与故障排除

提升警报系统可靠性需关注以下优化点:

- 减少噪音干扰:

- 排除非业务时段数据(如夜间系统维护导致的错误警报);

- 采用“冷却期”设置(如同一指标触发后2小时内不重复报警)。

- 动态阈值优化:

- 结合时间智能函数(如DATEADD)实现季节性基线调整(如电商大促期阈值放宽);

- 利用机器学习(如Azure Anomaly Detector)替代静态规则。

- 故障排查:

- 检查数据源刷新延迟:确认ETL管道是否影响警报触发;

- 验证权限设置:报表使用者需具备“警报”权限(管理员可在权限管理中分配);

- 测试DAX表达式:通过“性能分析器”排查因复杂计算导致的延迟。

通过上述配置,Power BI警报可从被动分析升级为主动防御,显著提升业务决策效率。

八、多维度选品评分卡:自定义权重与算法实现

构建科学的多维度选品评分卡是提升选品效率与准确性的核心工具。其关键在于通过量化指标与动态权重算法,将复杂的选品决策转化为可执行的标准化流程。以下从权重设计与算法实现两个维度展开解析。

1. 动态权重配置逻辑

权重配置是评分卡的灵魂,需根据业务目标灵活调整。首先,确定核心评估维度,如利润率、市场需求、竞争强度、供应链稳定性等,每项维度需匹配明确的计算指标。例如,利润率可细化为毛利率与净利润率,市场需求可引用搜索指数或历史销量数据。权重的分配需结合战略优先级:若以短期盈利为目标,可赋予利润率40%的权重;若以市场渗透为导向,可提升竞争强度与市场需求的权重至30%以上。为实现动态调整,可引入AHP(层次分析法)模型,通过专家打分或历史数据回归,自动校准各维度权重。例如,当竞品价格波动时,系统可临时调高价格敏感度的权重,确保评分卡实时响应市场变化。

2. 评分算法与权重聚合机制

评分算法需兼顾公平性与可扩展性。第一步,对原始数据进行标准化处理,消除不同指标量纲的影响。可采用Min-Max归一化将数据映射到[0,1]区间,或Z-score标准化处理异常值。第二步,结合权重计算加权得分,公式为:综合得分 = Σ(维度得分 × 权重系数)。例如,某产品利润率得分为0.8(权重40%),市场需求得分为0.6(权重30%),竞争强度得分为0.7(权重30%),则综合得分为0.8×0.4 + 0.6×0.3 + 0.7×0.3 = 0.71。为避免单一维度过度影响结果,可引入惩罚机制:若某项关键指标(如断货风险)低于阈值,直接触发一票否决。第三步,通过可视化看板展示得分分布,结合帕累托分析筛选高分项,辅助决策。算法实现可依赖Python的Pandas库进行数据处理,Scikit-learn库调用权重优化模型,最终通过API接口与选品系统打通,实现自动化评分。

通过动态权重与算法的深度结合,评分卡不仅能量化产品潜力,更能成为策略迭代的数字化引擎。

九、跨平台数据整合:结合第三方API扩展分析维度

1. . 多源API接入策略:构建统一数据管道

跨平台数据整合的核心在于高效、稳定地接入来自第三方平台的数据接口,并将其转化为可供分析的标准化结构。首先,需制定明确的API接入策略,依据业务需求优先级,对数据源进行分级。例如,电商分析需优先整合支付网关(如Stripe、支付宝)的交易流、物流服务商(如FedEx、顺丰)的实时轨迹,以及社交媒体平台(如Twitter、微博)的用户情感数据。技术上,应采用适配器模式,为不同API(RESTful、GraphQL、SOAP等)设计统一的数据接入层,封装认证、限流、重试等通用逻辑。同时,建立API网关作为流量入口,实现路由转发、协议转换与安全防护,确保数据管道的健壮性。对于高频或关键数据源,可部署Webhook订阅机制,变轮询为事件驱动,降低延迟与服务器负载。

2. . 数据标准化与映射:消除语义孤岛

第三方API返回的数据格式、字段定义及更新频率千差万别,直接合并会导致分析维度混乱。因此,必须实施严格的数据标准化流程。第一步是字段映射,通过预设的规则引擎,将各平台异构字段(如“user_id”“customer_id”“openid”)统一映射至数据仓库的公共数据模型。第二步是数据清洗,处理缺失值、异常值及重复数据,例如,通过正则表达式标准化地址格式,或利用机器学习模型识别并修正异常交易金额。第三步是语义统一,将不同业务场景下的相似指标进行归一化,如将“点击率”“转化率”等指标的计算逻辑统一为行业标准公式。此外,需建立元数据目录,记录每个数据源的来源、更新时间、可信度等级,为后续分析提供可追溯性。此过程可通过ETL工具自动化执行,确保数据实时性与一致性。

3. . 动态维度扩展与实时分析:驱动智能决策

整合后的多源数据能够显著扩展分析维度,但关键在于实现维度的动态扩展与实时响应。通过构建虚拟数据层,允许分析人员基于业务需求灵活组合来自不同API的数据维度,例如,将天气API的温度数据与外卖平台的订单量结合,分析气候对消费行为的影响。技术层面,可采用流处理引擎(如Apache Flink)对实时数据流进行关联计算,例如,将社交媒体的舆情趋势与股票行情API的价格波动进行毫秒级关联分析,生成预警信号。同时,引入机器学习模型,自动发现隐藏的高阶维度,如通过用户行为序列与第三方信用评分数据,构建用户风险画像。为确保分析结果的时效性,需建立缓存机制(如Redis)对高频查询数据进行预聚合,并设置自动刷新策略。最终,通过可视化平台(如Tableau、Power BI)将扩展后的分析维度以交互式仪表盘呈现,支持业务方进行多维度下钻与因果推断,实现数据驱动的动态决策。

十、权限管理与数据安全:企业级仪表盘部署方案

1. 基于角色的访问控制(RBAC)设计

企业级仪表盘的权限管理核心在于构建精细化、可扩展的RBAC模型。首先,需定义清晰的角色层级,例如“超级管理员”、“部门主管”、“业务分析师”及“只读用户”,严格限制每个角色的操作边界。超级管理员拥有系统全部权限,包括用户管理、数据源配置与权限分配;部门主管仅能查看其管辖范围内的数据,并管理本部门用户的仪表盘访问权;业务分析师可创建和编辑个人仪表盘,但发布需经审批;只读用户则仅能被授权查看特定仪表盘,无任何编辑或导出权限。其次,权限分配需遵循最小化原则,通过动态授权机制,将数据集、仪表盘组件(如图表、筛选器)甚至具体字段的可见性与角色绑定。例如,销售部门仪表盘可隐藏“成本利润”字段,仅向财务角色开放。最后,所有权限变更操作必须记录审计日志,确保行为可追溯,防止权限滥用。

2. 数据全链路安全防护

数据安全需贯穿从数据源 ingestion 到前端呈现的全流程。在数据传输层,必须启用TLS 1.3加密协议,确保数据在客户端与服务器之间的通信机密性,防止中间人攻击。数据存储层面,敏感数据(如客户身份证号、财务指标)应采用AES-256静态加密,且密钥管理需通过硬件安全模块(HSM)或云服务商提供的KMS服务实现,避免密钥泄露风险。针对数据接口,实施严格的API访问控制,结合OAuth 2.0认证与JWT令牌校验,限制接口调用频率与IP白名单,防止未授权爬取。此外,需建立数据脱敏机制,对开发测试环境或非核心用户展示的数据进行动态掩码处理,例如将手机号显示为“138****1234”,在保证数据可用性的同时降低泄露风险。

3. 安全审计与合规性保障

持续的监控与审计是维护仪表盘安全的关键。部署实时日志分析系统(如ELK Stack或Splunk),集中收集用户登录、权限变更、数据查询等操作日志,通过预设规则自动触发异常行为告警,例如短时间内大量数据导出或非工作时间登录尝试。定期进行渗透测试与漏洞扫描,模拟攻击场景检验系统防御能力,及时修补高危漏洞。对于涉及个人隐私或金融数据的行业,需确保仪表盘符合GDPR、等保2.0等法规要求,明确数据主体权利(如访问、删除请求)的处理流程,并生成合规性报告。同时,建立灾备体系,通过每日增量备份与全量快照相结合的策略,确保在数据损坏或勒索软件攻击时能快速恢复,保障业务连续性。

十一、移动端适配:选品决策的实时响应优化

在以移动端为主导的电商时代,消费者的购物决策路径变得前所未有的短暂与动态。用户在碎片化的时间里,通过手机屏幕快速滑动、比较与决策。这种场景要求选品系统必须具备极致的实时响应能力,将“人货场”的匹配效率压缩至毫秒级别。移动端适配不再是简单的界面缩放,而是贯穿数据采集、算法计算、策略执行全链路的深度优化,核心目标是确保在用户产生兴趣的瞬间,为其呈现最精准的商品,从而最大化转化率。

1. 从“人找货”到“货找人”:数据流的实时重构

传统PC时代的选品逻辑多为“人找货”,用户通过搜索或明确的类目导航寻找商品。移动端则彻底颠覆了这一模式,信息流推荐成为主流,“货找人”成为核心。这一转变要求选品决策的数据流必须是实时且闭环的。首先,用户的行为数据,如页面停留时长、点击热力图、滑动速度甚至微小交互,都需通过轻量级SDK实时上报,并与后端数据流无缝对接。其次,算法模型需基于此进行秒级迭代更新,而非传统的T+1批量处理。例如,当系统检测到某用户在短时间内连续浏览多款“露营帐篷”时,应立刻触发关联选品策略,实时推送“防潮地垫”或“便携露营灯”等高关联商品。这种响应的滞后性超过数秒,用户注意力便已转移,决策窗口随即关闭。因此,构建一个低延迟、高吞吐的实时数据管道是移动端选品优化的基石。

2. 场景化与个性化:算法模型的轻量化与精准化升级

移动端交互场景的复杂性与多样性,对选品算法提出了更高要求。算法不仅要“懂你”,更要“懂你当下的场景”。这意味着模型需要融合更多维度的弱信号,如地理位置、时间(工作日/周末、白天/夜晚)、网络环境(Wi-Fi/5G/4G)甚至设备电量,构建动态用户画像。例如,在写字楼区域午间时段,算法应优先推荐轻食、简餐或便携式办公用品;而在晚间住宅区,则可侧重家居生活或娱乐类商品。为在移动端有限的算力下实现这种复杂的实时计算,模型的轻量化至关重要。可采用“云-端”协同策略,在云端部署复杂模型进行深度特征挖掘与训练,再将轻量化的推理模型或预计算结果下发至客户端,实现毫秒级的本地响应。同时,利用强化学习等技术,让算法根据用户对推荐商品的即时反馈(点击、跳过、购买)进行在线学习与策略微调,形成一个“预测-推送-反馈-校正”的敏捷闭环,持续提升选品的精准度与转化效率。

十二、性能监控与迭代:仪表盘效果评估方法

1. 核心指标量化评估

仪表盘的效能需通过可量化的核心指标进行客观评估。首先是响应时间与加载效率,需监控仪表盘首次加载时间(FCP)、最大内容绘制时间(LCP)及交互响应延迟(TTI),确保核心数据在3秒内呈现,交互操作延迟低于200毫秒。其次是数据准确性与实时性,通过对比数据源与仪表盘显示值的偏差率(需控制在0.1%以内),并统计数据更新延迟(实时场景应低于5秒)。最后是用户行为漏斗分析,追踪关键操作路径(如数据筛选、钻取、导出)的完成率,识别高跳出率节点(如超过30%的步骤需优化)。这些指标需通过APM工具(如Prometheus、Grafana)持续采集,结合基线值动态调整预警阈值。

2. 用户体验定性分析

量化数据需结合用户行为深度分析以发现隐性痛点。热力图与会话回放可直观展示用户注意力分布及操作卡点,例如若80%用户频繁点击非交互区域,则表明视觉引导存在歧义。A/B测试是验证迭代效果的关键手段,需针对单变量(如图表类型、布局结构)设计对照实验,通过统计显著性检验(如p<0.05)确认优化方案的普适性。此外,用户反馈闭环必不可少,需建立分级反馈机制:高频问题(如“数据加载失败”)需纳入紧急修复池,而建议类反馈(如“增加对比维度”)则按优先级纳入迭代计划。定性分析应每季度产出用户画像报告,明确不同角色(如运营、技术决策者)的核心诉求差异。

3. 迭代与持续优化机制

评估结果必须转化为可执行的优化策略。问题分级处理机制要求将性能瓶颈分为三级:P0级(如响应超时导致不可用)需24小时内修复,P1级(如图表渲染错误)需72小时内解决,P2级(如UI细节优化)纳入下个迭代周期。灰度发布策略能降低全量风险,新版本先推送至5%用户,监控错误率(<0.01%)和性能指标波动,确认无回退后再逐步扩大覆盖。同时,数据驱动决策需落地为具体规范:例如当某图表点击率低于15%时,默认触发重构流程。迭代效果需通过双重验证——指标回归测试(确保新版本未引入性能回退)与用户满意度调研(NPS评分需持续提升)。最终形成“监控-分析-优化-验证”的闭环,每季度输出《仪表盘健康度报告》,量化迭代ROI(如加载优化带来的用户停留时长提升百分比)。