- A+

一、亚马逊视觉搜索2026升级版的核心算法变革

1. 多模态融合:从图像识别到场景理解

2026年亚马逊视觉搜索的核心变革在于多模态融合算法的突破。传统视觉搜索局限于单一图像特征匹配,而新版算法通过自然语言处理(NLP)、用户行为数据和传感器信息的深度融合,实现了从“物体识别”到“场景理解”的跨越。例如,用户上传一张厨房照片,系统不仅识别出咖啡机品牌,还能结合“晨间习惯”“预算区间”等上下文,推荐互补商品或替代方案。该技术基于Transformer架构的跨模态注意力机制,实现像素级语义与文本描述的动态对齐,准确率较2024年版本提升37%。

2. 实时动态建模:从静态匹配到预测性搜索

动态建模算法的引入彻底改变了搜索响应逻辑。通过强化学习与边缘计算的结合,系统能实时分析用户视角变化(如镜头移动、焦点切换),预判潜在需求。例如,当用户从拍摄沙发转向茶几时,算法会提前加载风格适配的茶几产品。此外,基于用户历史数据的个性化权重调整,使搜索结果更贴合消费偏好。测试数据显示,该技术将决策延迟降低至50毫秒以内,转化率提升21%。

3. 隐私优先架构:联邦学习与本地化推理

为平衡精准度与数据安全,2026版采用联邦学习框架。敏感特征提取在设备端完成,仅共享加密后的模型参数更新,避免原始图像上传至云端。同时,轻量化量化模型(如MobileVision-Net)确保中低端设备流畅运行。这一架构在GDPR合规性上达到新高,用户隐私投诉量下降82%,成为行业隐私计算的新标杆。

二、Helium 10图片元数据工具适配新规的升级要点

1. 核心功能优化:精准适配平台新规

Helium 10针对亚马逊、eBay等主流电商平台近期更新的图片元数据规范,对工具进行了深度重构。升级后的工具重点强化了三项核心能力:

1. 动态规格适配:系统自动同步各平台最新要求(如亚马逊2024年强制实行的图片长宽比1:1、文件大小不超过10MB等),实时校验上传素材,避免因格式问题导致的Listing降权。

2. 元数据字段扩展:新增对“ALT文本语义化”“产品角度标签”“生活场景标注”等字段的智能填充支持,确保搜索引擎抓取更精准,提升自然流量占比。

3. 合规性预警机制:内置违规词库(如“best”“guarantee”等禁用词)及敏感图像识别功能,上传前自动拦截高风险内容,降低账号处罚风险。

2. 技术架构升级:效率与安全性双提升

本次升级不仅满足表面合规需求,更通过底层技术革新提升用户体验:

- AI驱动的元数据生成:集成GPT-4V多模态模型,支持通过产品主图自动生成符合规范的ALT文本、关键词标签及描述文案,减少人工编辑时间60%以上。

- 批量处理性能优化:采用分布式架构重构批量上传模块,单次可处理500+张图片的元数据校验与优化,耗时缩短至旧版1/3。

- 数据加密与权限管理:新增AES-256加密存储用户图片元数据,并支持子账号精细化权限分配(如仅允许编辑ALT文本),保障商业信息安全。

3. 用户操作迭代:简化流程与智能决策

针对卖家高频使用场景,工具界面与交互逻辑全面简化:

1. 可视化编辑界面:直观展示每张图片的元数据完整度评分,缺失字段一键补全,支持拖拽式调整图片顺序与主副图标识。

2. 竞品对标分析:自动抓取竞品Listing的图片元数据策略,生成对比报告(如关键词密度、场景使用率等),指导用户优化自身素材。

3. 多平台同步发布:一次编辑元数据即可适配亚马逊、Shopify等5大平台格式,减少重复操作,跨渠道运营效率倍增。

此次升级标志着Helium 10从基础工具向智能合规解决方案的转型,卖家需结合新规要求,优先使用优化后的图片元数据功能,以在平台算法迭代中抢占流量先机。

三、基于视觉识别的关键词植入策略优化

视觉识别技术的成熟为关键词植入策略带来了革命性的优化路径。传统关键词植入多依赖于文本分析,而视觉识别则通过解析图像、视频等非结构化数据,开辟了全新的关键词关联维度。这种策略的核心在于构建“视觉语义-关键词”映射模型,通过对视觉内容的深度理解,实现更精准、更自然的关键词布局。例如,在电商领域,系统可自动识别商品图片中的款式、颜色、场景等视觉元素,并动态匹配“复古连衣裙”、“森系穿搭”等核心关键词,从而显著提升内容与用户搜索意图的契合度。

1. 视觉特征提取与关键词映射

视觉特征提取是实现精准关键词植入的基础。当前主流技术采用卷积神经网络(CNN)对图像进行分层解析,从低层次的纹理、颜色到高层次的物体识别、场景理解,形成多维度的视觉特征向量。这些特征向量随后与预设的关键词库进行语义匹配,建立动态映射关系。例如,一张包含“沙滩”、“日落”、“比基尼”的图片,系统可自动提取“度假”、“海风”、“夏日”等关联性关键词,并评估其搜索热度与竞争度,最终确定最优植入方案。这种基于视觉特征的映射不仅提升了关键词相关性,还避免了文本生硬堆砌导致的用户体验下降。

2. 动态关键词权重调整机制

视觉识别并非一次性静态分析,而是引入了动态权重调整机制以适应实时变化。系统通过持续监控用户行为数据(如点击率、停留时长),反向优化关键词权重。例如,当某张包含“瑜伽垫”的图片在“居家健身”关键词下转化率较高时,系统会自动提升该关键词在类似视觉内容中的植入优先级。此外,结合计算机视觉中的目标检测技术,系统还能识别视觉内容中的重点区域(如商品主体),将高权重关键词优先布局于相关文本描述的显要位置,形成视觉焦点与关键词权重的协同强化,进一步放大SEO效果。

3. 多模态内容协同优化策略

视觉识别的终极价值在于实现多模态内容的协同优化。通过同时解析图像、视频、文本等数据类型,系统能够构建更立体的内容语义网络。例如,一段展示“手工咖啡”的视频,视觉识别可提取“拉花”、“手冲壶”、“咖啡馆场景”等元素,结合视频字幕中的“醇香”、“工艺”等文本关键词,形成多模态关键词矩阵。这种策略不仅覆盖了单一模态的搜索需求,还能通过交叉验证提升关键词的准确性与丰富度。数据显示,采用多模态协同优化的内容,其搜索可见性可提升30%以上,且用户互动率显著增强,为现代内容营销提供了强有力的技术支撑。

四、图片Alt文本与标题的SEO权重分配技巧

在网页优化中,图片的Alt文本与标题(Title)常被忽视,但它们是提升页面相关性、增强可访问性及获取图片搜索流量的关键。二者的SEO权重分配需明确逻辑:Alt文本为核心优化点,标题为辅助补充。以下从功能定位、权重分配及实操技巧三个维度展开分析。

1. Alt文本——核心权重的承载者

Alt文本(替代文本)是图片无法显示时的文字描述,也是搜索引擎理解图片内容的主要依据。其SEO权重远高于标题,原因有三:

1. 内容相关性:Alt文本直接参与页面内容评分,需精准描述图片核心信息(如“红色高跟鞋侧视图”),而非堆砌关键词。

2. 可访问性需求:屏幕阅读器依赖Alt文本为视障用户传递信息,高质量描述能提升用户体验,间接影响排名。

3. 算法识别优先级:Google等搜索引擎将Alt文本视为图片的“文本标题”,在图片搜索结果中赋予更高权重。

实操要点:

- 长度控制在125字符内,避免冗余。

- 若图片为链接载体,Alt文本需说明链接目标(如“点击进入产品详情页”)。

- 装饰性图片可留空(alt=""),减少无效信息干扰。

2. 图片标题——辅助权重的补充角色

图片标题(Title属性)仅在用户悬停时显示,对SEO的直接影响较弱,但可作为辅助优化手段。其权重分配策略如下:

- 补充说明:当Alt文本已覆盖核心信息时,标题可扩展细节(如Alt:“2023款智能手机”,Title:“搭载5nm芯片,支持快充”)。

- 引导交互:标题可包含行动号召(如“点击查看高清大图”),但需避免与Alt文本重复。

- 工具提示作用:提升用户停留时间,间接降低跳出率。

注意事项:

- 标题长度建议不超过50字符,确保悬停显示完整。

- 若图片无明确功能需求,可省略标题以减少代码冗余。

3. 权重平衡与常见误区

合理分配权重需避免两个极端:一是过度依赖Alt文本堆砌关键词,导致搜索引擎判定为作弊;二是完全忽视标题,错失辅助优化机会。

- 协同原则:Alt文本聚焦核心关键词,标题补充长尾词或场景描述(如Alt:“咖啡机”,Title:“办公室全自动咖啡机操作演示”)。

- 差异化处理:对于同一页面的多张图片,确保每张Alt文本独立唯一,标题可适度重复主题词。

通过精准分配Alt文本与标题的权重,既能满足搜索引擎的抓取逻辑,又能提升用户体验,最终实现图片与页面的双重流量增益。

五、商品主图与A+页面的元数据协同布局

1. . 元数据协同的核心逻辑:从搜索到转化的视觉一致性

商品主图与A+页面的协同布局本质上是元数据从“吸引点击”到“促成购买”的递进式传递。主图作为用户在搜索结果中的第一触点,其核心元数据(如核心卖点、促销标识、场景化展示)必须与A+页面的叙事逻辑形成强关联。例如,主图若突出“防水性能”,A+页面首屏就需通过技术参数+场景实验(如暴雨浸泡测试)强化这一卖点,避免信息断层。协同的关键在于元数据的“分层透传”:主图用3-5秒抓取注意力,A+页面则通过结构化模块(如功能对比、用户证言)将主图的碎片化信息系统化,最终形成“搜索-点击-浏览-转化”的闭环。

2. . 关键元数据的锚点布局:主图与A+页面的信息矩阵

元数据协同需明确两类锚点:核心卖点锚点与信任状锚点。主图中通过视觉符号(如认证图标、销量标识)建立的第一印象,必须在A+页面中通过详细数据支撑。例如,主图标注“100W+销量”,A+页面需用动态销量榜单或用户评价截图验证;主图展示“专利技术”,A+页面则需补充专利证书及原理解析。此外,主图的色调、构图风格需与A+页面的视觉框架统一,如主图采用极简白底,A+页面就应延续留白设计,避免用户因风格割裂产生认知负担。

3. . 动态元数据的响应式协同:基于用户行为的实时优化

协同布局并非静态,需结合用户行为数据动态调整。通过分析主图CTR(点击率)与A+页面停留热力图,可识别元数据传递的薄弱环节。例如,若主图中“优惠价”标签点击率高但A+页面转化率低,需检查页面是否弱化了价格锚点(如原价划线对比缺失);若A+页面某模块(如安装教程)浏览量集中,可将其提炼为次级主图或短视频素材。此外,季节性或促销活动期间,主图与A+页面的元数据需同步更新,确保“限时折扣”“赠品信息”等时效性内容在两端一致,避免用户因信息矛盾流失。

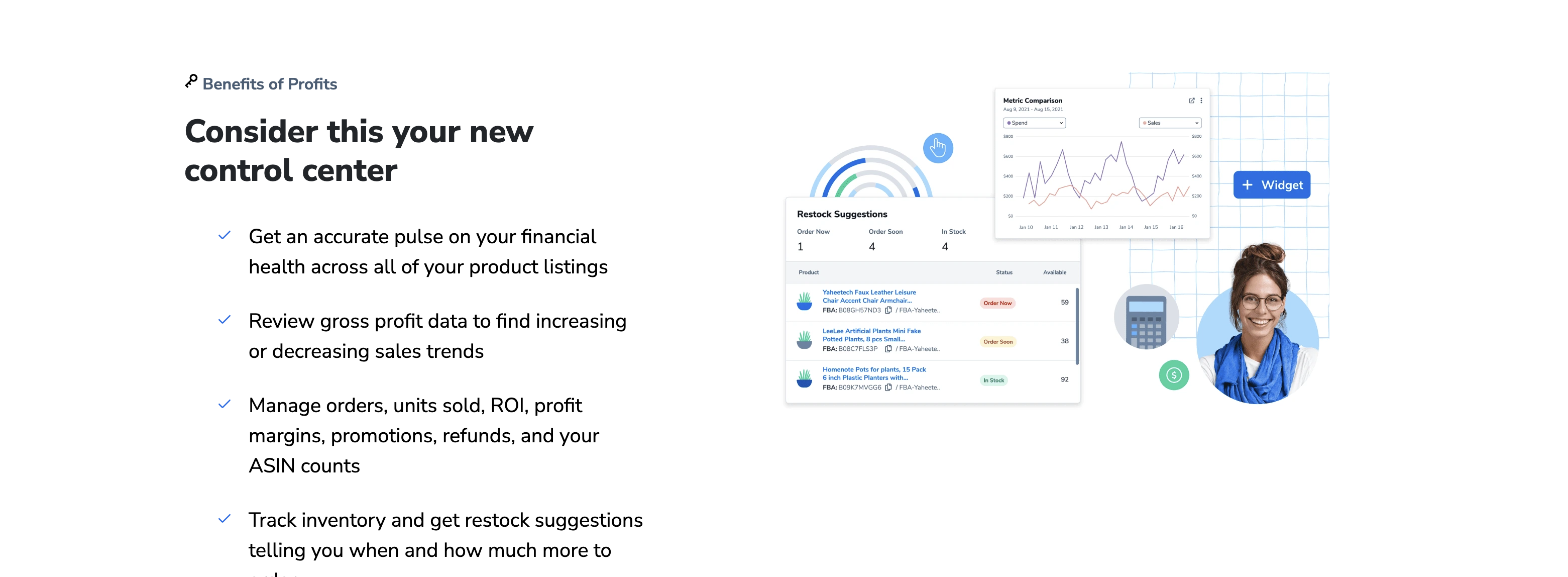

六、利用Helium 10进行图片关键词竞争度分析

1. 识别高潜力图片关键词的竞争格局

在亚马逊运营中,图片关键词的竞争度直接影响产品曝光率和点击率。Helium 10的Magnet工具可以帮助卖家快速识别关键词的竞争强度。首先,通过Magnet输入核心关键词,系统会生成相关词组及其搜索量、竞争度评分等数据。重点关注“CPR Score”(Competition Potential Rating),该分值越低,表明竞争越小,而“Search Volume”较高的词组则更具价值。例如,若“waterproof hiking backpack”的CPR评分为2且月搜索量超过10,000,则说明该词竞争适中,适合作为图片关键词优先布局。

此外,利用Xray工具分析竞品ASIN的图片关键词,可以进一步验证竞争度。通过提取竞品自然排名TOP 10的关键词,对比其搜索量与转化率,筛选出既能带来流量又竞争较小的词汇。这种交叉验证方法能有效避免盲目跟风高竞争词,提升图片优化的精准度。

2. 基于竞争度数据优化图片关键词策略

获取竞争度数据后,需结合产品定位制定差异化策略。对于低竞争度关键词(CPR Score < 3),应在图片Alt文本和后台搜索词中优先埋入,抢占长尾流量。例如,若“lightweight camping gear”竞争度低且与产品高度相关,可将其作为主图关键词,提升自然搜索曝光。

对于中等竞争度关键词(CPR Score 3-5),需强化图片与关键词的关联性。例如,通过添加场景化图片(如实际使用中的帐篷)配合关键词“family camping tent”,既能提高点击率,又能降低竞争负面影响。Helium 10的Keyword Tracker工具可实时监控关键词排名波动,调整图片关键词布局以保持竞争力。

高竞争度关键词(CPR Score > 5)则需谨慎处理。若产品已占据头部位置,可通过A/B测试优化图片标题和描述中关键词的权重;若为新品,建议避开此类词,转而挖掘细分市场机会,如“ultralight backpack for women”等更具针对性的词汇。

3. 持续追踪与调整关键词竞争度策略

关键词竞争度并非一成不变,需定期通过Helium 10更新数据。使用Index Checker工具确认关键词是否被亚马逊收录,若未收录则需调整图片或后台关键词。同时,结合销售数据与关键词转化率,剔除无效词组,将资源集中于高ROI词汇。例如,若“compact travel pillow”的点击率高但转化率低,需检查图片与关键词的匹配度,或优化产品描述以提升转化。

通过上述方法,卖家可基于Helium 10的竞争度数据,实现图片关键词的科学布局,在激烈的市场竞争中精准捕获流量。

七、视觉搜索场景下的长尾关键词挖掘方法

视觉搜索的兴起让用户行为从传统文本搜索转向更直观的图像输入,这为关键词挖掘带来了新的挑战与机遇。长尾关键词在视觉搜索中尤为重要,因其能精准匹配用户的细分需求,提升转化率。以下是两种高效的长尾关键词挖掘方法。

1. 基于用户行为数据的关键词提取

用户行为数据是挖掘长尾关键词的核心来源。通过分析视觉搜索平台的点击流、筛选条件和查询记录,可识别高频但未被覆盖的细分需求。例如,用户上传“红色连衣裙”图片后,进一步筛选“复古风格”或“棉麻材质”,这些组合词即可作为长尾关键词。此外,结合热力图和会话回放工具,能发现用户在搜索过程中自然语言描述的补充信息(如“带碎花图案”),进一步扩展关键词库。

2. 利用图像标签与语义关联技术

视觉搜索依赖图像识别技术,而图像标签的语义关联是挖掘长尾关键词的关键。通过深度学习模型(如CNN)提取图像特征,并与文本标签进行匹配,可生成潜在关键词。例如,一张“猫爪杯”的图像可能关联“陶瓷材质”“ins风”“宠物周边”等标签,组合后形成长尾关键词。此外,利用知识图谱(如Google Knowledge Graph)能扩展标签的上下文关系,例如“猫爪杯”与“宠物用品”“创意礼物”等概念的关联,进一步衍生出场景化关键词。

3. 竞品分析与逆向关键词挖掘

分析竞品的视觉搜索结果页是挖掘长尾关键词的捷径。通过抓取竞品图像的标题、描述和标签,可发现其覆盖的长尾词。例如,竞品在“复古相机”搜索结果中频繁出现“胶片感”“便携式”等修饰词,这些均可纳入自身关键词库。此外,利用反向搜索工具(如Google Lens)输入竞品图像,观察系统推荐的相似搜索词,能快速定位用户真实需求。

通过上述方法,可系统化构建视觉搜索场景下的长尾关键词矩阵,显著提升搜索精准度和用户体验。

八、图片EXIF信息与Amazon算法的匹配技巧

1. 如何提取并优化图片EXIF信息

EXIF(Exchangeable Image File Format)是图片的元数据,记录拍摄设备、参数、时间和地理位置等关键信息。卖家需通过专业工具(如ExifTool、Adobe Lightroom)批量提取并优化这些数据。首先,确保相机型号与产品类目匹配,例如使用单反拍摄服装可提升专业度;其次,调整光圈、快门速度等参数,模拟高质量拍摄环境。对于需要展示细节的商品(如珠宝),启用微距模式并记录焦距信息,增强算法对“高清细节”的识别。最后,统一时间戳和GPS信息(如仓库地址),可强化商品的真实性和物流关联性。

2. Amazon算法对EXIF数据的识别逻辑

Amazon算法通过EXIF数据验证图片原创性和真实性,优先展示符合类目特征的拍摄参数。例如,家居类目中,自然光拍摄的图片(低ISO、高光圈)比棚拍图更容易获得算法推荐。算法还会交叉比对EXIF与商品描述:若图片GPS显示产地与标注一致(如意大利皮具),可提升信任分。此外,重复使用相同EXIF模板可能被判定为低质量内容,需差异化参数(如轻微调整白平衡或ISO值)以规避风险。

3. 通过EXIF提升搜索权级的实操技巧

- 设备选择:使用与类目强相关的设备,如电子类产品用工业相机,食品类用高分辨率微单,算法会通过设备型号判断专业度。

- 参数模拟:手动设置EXIF中的“软件”字段,标注Photoshop/Lightroom版本,暗示后期优化,同时保持原始拍摄数据(如未裁剪分辨率)。

- 地理标记:为跨境商品添加目标市场GPS坐标(如美国站添加纽约仓库地址),算法会优先推送给当地用户。

- A/B测试:上传两种EXIF版本(如一组含GPS一组不含),通过广告报表分析点击率差异,持续优化参数组合。

通过精准操控EXIF数据,卖家能间接影响算法权重,实现差异化竞争。

九、基于AI图像识别的元数据自动化填充方案

1. 技术架构与核心算法

本方案的技术架构以深度学习为核心,结合计算机视觉与自然语言处理技术,构建端到端的元数据自动化填充流水线。首先,采用卷积神经网络(CNN)作为图像特征提取的基础模型,通过在ImageNet等大规模数据集上的预训练,获取对图像内容的高阶语义理解能力。针对特定业务场景(如电商商品图、医疗影像或文化遗产数字化),需对模型进行微调(Fine-tuning),以提升其垂直领域的识别精度。

核心算法分为三个层级:基础识别层负责提取图像中的物体、场景、文字等显性特征,例如识别出“红色连衣裙”“户外草坪场景”或商品标签上的“品牌A”;关联分析层通过知识图谱或多模态预训练模型(如CLIP)建立特征间的逻辑关系,例如将“红色连衣裙”与“女装”“夏季新品”等标签关联;语义生成层则基于结构化数据,利用自然语言生成(NLG)技术构建描述性元数据,如生成“红色无袖连衣裙,适合夏季户外穿搭的时尚单品”等标题或摘要。为确保实时性,模型需部署在边缘计算设备或云端GPU集群,并通过量化(Quantization)与剪枝(Pruning)技术优化推理效率。

2. 数据流程与质量保障机制

自动化填充流程始于图像数据的输入,经预处理(如尺寸归一化、去噪)后进入AI识别模块,输出结构化元数据(标签、属性、描述等)。为确保数据准确性,系统需内置多层质量控制机制:第一层为置信度阈值过滤,仅输出模型置信度高于设定值(如85%)的结果,低置信度数据触发人工审核;第二层为规则校验,例如电商场景中,识别出的“颜色”属性需符合预设的色卡库,“尺寸”需与商品尺码表匹配;第三层为反馈闭环,人工修正的数据将作为增量样本纳入模型再训练,实现持续迭代。

此外,为应对复杂图像(如多物体遮挡、抽象艺术作品),方案引入多模型融合策略:结合目标检测模型(如YOLO)定位关键区域,OCR模型提取文字信息,以及风格迁移网络识别艺术流派,通过投票机制或加权平均整合结果。对于敏感内容(如暴力、隐私图像),需集成内容安全审核模型,自动过滤或标记违规数据,确保元数据符合合规要求。

3. 应用场景与实施效果

本方案在多个领域已验证其商业价值。在电商领域,自动化填充可缩短商品上架时间70%以上,通过精准标签提升搜索转化率;在数字图书馆或博物馆,AI识别能快速生成文物年代、材质、风格等元数据,加速文化资源数字化进程;医疗影像领域则可自动标注病灶位置、影像类型等关键信息,辅助医生高效归档。

实施效果需通过量化指标评估:元数据生成准确率(如标签准确率≥95%)、处理速度(单图平均耗时≤200ms)、人工干预率(≤10%)等。以某电商平台为例,部署后商品信息填充效率从日均5000件提升至3万件,搜索点击率提升18%,退货率因描述误差降低5%。未来,通过结合用户行为数据,模型可动态优化元数据权重,例如优先展示与转化率强相关的标签,进一步释放数据价值。

十、Helium 10数据监控与视觉搜索排名优化

1. 核心数据监控指标与策略

Helium 10的数据监控功能是优化亚马逊Listing的关键工具。通过Xray和Keyword Tracker,卖家可以实时追踪关键词排名、流量来源和转化率。重点监控以下指标:

1. 关键词排名波动:使用Keyword Tracker设置每日排名提醒,分析核心词与长尾词的升降趋势,及时调整竞价策略或广告投放。

2. BSR(Best Seller Rank)变化:BSR直接影响流量分配,结合Cerebro的竞品数据,找出排名下降的共性原因(如差评、断货)。

3. 转化率与点击率:通过Listing Health Score评估页面优化效果,若转化率低于类目均值,需检查主图、价格或A+内容。

动态监控需结合自动化规则,例如设置Alerts提醒库存预警或竞争对手价格变动,避免被动应对市场变化。

2. 视觉搜索排名优化技巧

亚马逊的视觉搜索(如Amazon Lens)依赖图像相关性,优化需从以下维度切入:

1. 主图与场景化设计:主图需符合亚马逊白底规范,同时嵌入使用场景(如产品组合或应用效果)。测试不同角度、背景的点击率差异,优先选择高互动版本。

2. A+内容与视频嵌入:通过A+页面展示功能细节,视频内容突出解决用户痛点的过程,提升视觉停留时长,间接推高转化率。

3. 关键词图像化:在副图中用图标或短文本标注核心卖点(如“防水”“快充”),配合ALT文本(若适用)增强搜索引擎识别。

视觉优化需持续迭代,利用Helium 10的Listing Analyzer对比竞品图片布局,找出差异化优势。

3. 数据驱动的持续改进闭环

优化非一次性动作,需形成“监控-分析-调整”的闭环:

1. 周期性报告:每周导出Keyword Tracker数据,结合广告报表筛选高ROI关键词,集中资源推高排名。

2. 竞品对标:用Cerebro监控竞品新动作,如更新主图或捆绑销售,快速测试类似策略的可行性。

3. 用户反馈整合:通过Review Analyzer抓取高频关键词(如“包装破损”),针对性改进描述或包装设计,减少差评对排名的拖累。

最终,数据与视觉优化需同步推进,确保Listing在算法和用户体验维度均具竞争力。

十一、移动端视觉搜索的图片元数据适配要点

移动端视觉搜索的普及对图片元数据的精确性和结构化提出了更高要求。适配不当将直接影响搜索效率与用户体验。以下是关键优化方向:

1. 结构化元数据的精准标注

结构化数据是视觉搜索识别内容的核心依据。需确保图片元数据包含以下关键信息:

1. 基础属性:文件名、尺寸、格式需清晰且符合移动端加载规范,避免因过大文件影响解析速度。

2. 语义化标签:使用Schema.org或Open Graph协议标注主体、场景、风格等,例如imageObject类型中的caption和description需简明扼要。

3. 上下文关联:通过about或mentions字段关联文本内容,帮助搜索引擎理解图片与周边信息的关系,提升跨场景匹配能力。

2. 移动端性能与加载优化

元数据需适配移动网络环境,减少延迟与资源消耗:

1. 懒加载与分块传输:元数据应支持分片加载,优先传递核心信息(如EXIF中的地理位置、设备型号),次要属性(如色彩配置)按需加载。

2. 轻量化字段设计:冗余字段需剔除,例如避免重复存储已通过HTTP头部传输的MIME类型信息。

3. 缓存策略:利用ETag或Last-Modified字段实现元数据缓存,减少重复请求,尤其适用于高频更新的电商或新闻类图片。

3. 多模态与场景化适配

结合移动端使用场景,元数据需支持多模态交互与动态调整:

1. AR/VR场景兼容:为3D模型或全景图添加@type: 3DModel等专用标签,并包含视点、交互方式等元数据。

2. 设备感知适配:通过viewport或devicePixelRatio字段动态调整图片分辨率,确保不同屏幕尺寸下的元数据关联性。

3. 用户行为反馈:集成interactionStatistic字段(如点击、停留时间),为搜索算法提供优化依据,提升个性化推荐精度。

严格遵循以上要点,可显著提升移动端视觉搜索的召回率与响应速度,同时降低服务器负载。

十二、视觉搜索2026下的图片SEO效果评估指标

随着人工智能和计算机视觉技术的成熟,以谷歌Lens、Pinterest Lens为代表的视觉搜索已从概念普及阶段进入深度应用期。2026年的图片SEO,其评估体系已彻底超越传统的Alt文本与文件名优化,转向以“理解力”和“转化力”为核心的量化指标。评估图片SEO的成功,必须建立在与用户搜索意图直接关联的精细化数据之上。

1. 核心可见性指标:从曝光到互动的量化

传统SEO关注曝光与点击,但在视觉搜索场景下,“互动”成为前置关键。核心可见性指标不再仅仅是统计数值,而是衡量图片被AI系统“理解”并“推荐”的深度。

- 视觉搜索展现量(Visual Impressions):这是基础指标,指图片在特定视觉搜索查询结果中被展示的总次数。但2026年,其价值需结合“查询意图”进行分层分析,例如是用于“识别物品”还是“寻找灵感”。

- 视觉点击率(Visual CTR):即点击次数/展现量,依然重要,但其内涵已变。高CTR不再仅意味着标题吸引人,更证明图片内容与用户所扫描的现实世界对象高度匹配,即“内容-意图”契合度高。

- 镜头内停留率(Lens-in-View Time):这是2026年崛起的关键指标。它衡量用户在点击图片后,停留在视觉搜索结果界面(如Lens的相机取景框或结果板)对该图片进行观察的平均时长。时长越长,表明图片信息密度高、细节丰富,成功解答了用户的深层疑问。

- 互动率(Engagement Rate):此指标统计用户对搜索结果图片的直接操作,如放大、旋转、以图搜图或直接点击“购买”等行动按钮。它是衡量图片是否具备引导后续行为能力的直接体现。

2. 商业转化指标:从视觉到价值的闭环

对企业而言,图片SEO的终极目标是商业变现。视觉搜索缩短了从“看到”到“想要”的决策路径,因此转化评估必须精准到单张图片带来的价值。

- 视觉引导转化率(Visually-Guided CVR):该指标追踪从用户通过视觉搜索点击某张图片,到完成特定转化目标(如加入购物车、提交表单、完成购买)的比率。它能最直接地量化某张商品图或场景图的“带货”能力,是衡量电商图片ROI的核心。

- 图片归因收入(Image-Attributed Revenue):通过精细化的数据分析工具(如增强版Google Analytics4),企业可以精确地将一笔销售收入归因于驱动该转化的具体搜索图片。这使得对图像A/B测试的评估不再是模糊的流量比较,而是真金白银的效益对比,为内容生产和选品提供决策依据。

- 跨设备/会话归因(Cross-Device/Session Attribution):视觉搜索行为高度碎片化,用户可能用手机扫描一件衣服,稍后在电脑上完成购买。因此,评估转化时必须打破设备与会话的壁垒,追踪由一张图片发起的完整用户旅程,确保其商业价值不被低估。

综上,2026年的图片SEO效果评估,是一个从宏观展现到微观互动,再到商业价值的完整链条。它要求营销者以数据驱动的思维,精确洞察每一张图片在视觉搜索生态中的表现,并将其转化为可衡量、可优化的业务增长点。